摘要:生成对抗网络( Generative Adversarial Networks, GAN)是通过对抗训练的方式来使得生成网络产生的样本服从真实数据分布。在生成对抗网络中,有两个网络进行对抗训练。一个是判别器,目标是尽量准确地判断一个样本是来自于真实数据还是由生成器产生;另一个是生成器,目标是尽量生成判别网络无法区分来源的样本 。两者交替训练,当判别器无法判断一个样本是真实数据还是生成数据时,生成器即达到收敛状态。以上是对生成对抗网络的简单描述,本文将对生成对抗网络的内在原理以及相应的优化机制进行介绍。

文章概览

- 概率生成模型

- 生成对抗网络

- 生成对抗网络的理论解释

- 生成对抗网络的求解过程

- 生成对抗网络的优化

- fGAN

- WGAN

- 生成对抗网络的实现

概率生成模型

概率生成模型,简称生成模型,是指一系列用于随机生成可观测数据的模型。假设在一个连续或离散的空间$\chi$中,存在一个随机向量$X$服从一个未知的数据分布$P_{data}(x)$,$x \in \chi$。生成模型是根据一些可观测的样本$x^1, x^2, …, x^m$来学习m一个参数化模型$P_G(\theta;x)$来近似未知分布,并可以用这$P_{data}(x)$个模型来生成一些样本,使得生成的样本和真实的样本尽可能的相似。对于一个低维空间中的简单分布而言,我们可以采用最大似然估计的方法来对$p_\theta(x)$进行求解。假设我们要统计全国人民的年均收入的分布情况,如果我们对每个$P_{data}(x)$样本都进行统计,这将消耗大量的人力物力。为了得到近似准确的收入分布情况,我们可以先假设其服从高斯分布,我们比如选取某个$P_G(x;\theta)$城市的人口收入$x^1, x^2, …, x^m$,作为我们的观察样本结果,然后通过最大似然估计来计算上述假设中的高斯分布的参数。

$$

L=\prod_{i=1}^{m} P_{G}\left(x^{i} ; \theta\right)

$$

$$

{\theta}^{*}=arg \max_{\theta} \sum_{i=1}^{m} \log P_{G}(x^{i} ; \theta)

$$

由于$P_G(x;\theta)$服从高斯分布,我们将其带入即可求得最终的近似的分布情况。下面我们对上述过程进行一些拓展,我们从$P_{data}(x)$尽可能采样更多的数据,此时可以得到

$$

{\theta}^{*}=arg \max_{\theta} \sum_{i=1}^{m} \log P_{G}(x^{i} ;\theta)\approx arg \max_{\theta} E_{x \sim P_{\text {data }}}[\log P_{G}(x ; \theta)]

$$

对该式进行一些变换,可以得到

$$

{\theta}^{*}=arg \min_{\theta} K L\left(P_{\text {data }} | P_{G}\right)

$$

由此可以看出,最大似然估计的过程其实就是最小化$P_{data}(x)$分布和$P_G $分布之间$KL$散度的过程。从本质上讲,所有的生成模型的问题都可以转换成最小化$P_{data}(x)$分布和$P_G $分布之间距离的问题,$KL$散度只是其中一种度量方式。

如上所述,对于低维空间的简单分布而言,我们可以显式的假设样本服从某种类型的分布,然后通过极大似然估计来进行求解。但是对于高维空间的复杂分布而言,我们无法假设样本的分布类型,因此无法采用极大似然估计来进行求解,生成对抗网络即属于这样一类生成模型。

生成对抗网络

生成对抗网络的理论解释

在生成对抗网络中,我们假设低维空间中样本$z$服从标准类型分布,利用神经网络可以构造一个映射函数$G$(即生成器)将$z$映射到真实样本空间。我们希望映射函数$G$能够使得$P_G(x)$分布尽可能接近$P_{data}(x)$分布,即$P_G$与$P_{data}$之间的距离越小越好:

$$

G^{*}=arg \min_{G} {\operatorname{Div}}\left(P_{G}, P_{\text {data }}\right)

$$

由于$P_G$与$P_{data}$的分布都是未知的,所以无法直接求解$P_G$与$P_{data}$之间的距离。生成对抗网络借助判别器来解决这一问题。首先我们分别从$P_G$与$P_{data}$中取样,利用取出的样本训练一个判别器:我们希望当输入样本为$P_{data}$时,判别器会给出一个较高的分数;当输入样本为$P_G$时,判别器会给出一个较低的分数。例如,我们可以将判别器的目标函数定义成以下形式(与二分类的目标函数一致,即交叉熵):

$$

V(G, D)=E_{x \sim P_{\text {data }}}[\log D(x)]+E_{x \sim P_{G}}[\log (1-D(x))]

$$

我们希望得到这样一个判别器($G$固定):

$$

D^{*}=arg \max_{D} V(D, G)

$$

从本质上来看,$\max _{D} V(D, G)$即表示$P_G$与$P_{data}$之间的$JS$散度(具体推导参见李宏毅老师的课程),即:

$$

\max_{D} V(G, D)=V\left(G, D^{*}\right)=-2 \log 2+2 J S D\left(P_{\text {data }} | P_{G}\right)

$$

$$

D^{*}(x)=\frac{P_{\text {data }}(x)}{P_{\text {data }}(x)+P_{G}(x)}

$$

因此通过构建判别器可以度量$P_G$与$P_{data}$之间的距离,所以$G^{*}$可以表示为:

$$

G^{*}=arg \min_{G} \max_{D} V(G, D)

$$

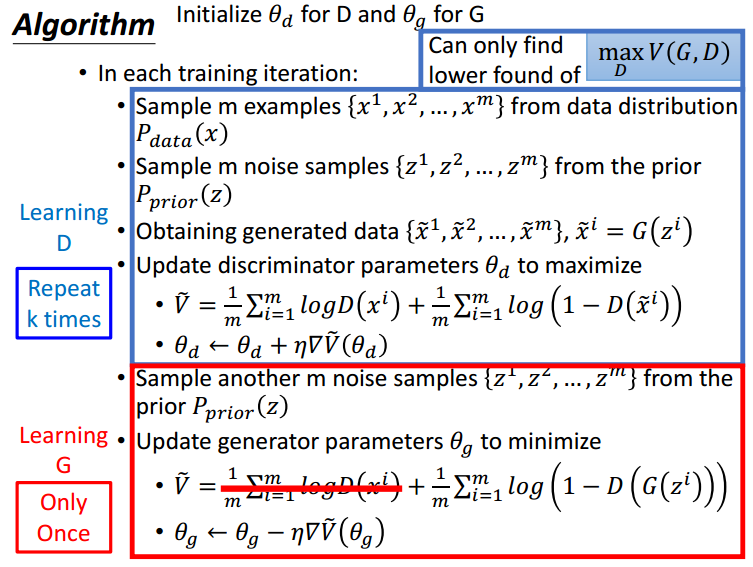

生成对抗网络的求解过程

$G^{*}$的求解过程大致如下:

- 初始化生成器$G$和判别器$D$

- 迭代训练

- 固定生成器$G$,更新判别器$D$的参数

- 固定生成器$D$,更新判别器$G$的参数

对上述算法过程进行几点说明:

- 在之前的描述中,$V(D,G)$表示的是目标函数的期望,但在实际计算过程中是通过采样平均的方式来逼近其期望值。

- 判别器的训练需要重复$k$次的原因是希望能尽可能使得$V(D,G)$接近最大值,这样才能满足$\max _{D} V(D, G)$即表示$P_G$与$P_{data}$之间的$JS$散度”这一假设。

- 在更新生成器参数时,$\frac{1}{m} \sum_{i=1}^{m} \log D\left(x^{i}\right)$这一项可以忽略,因为$D$固定,其相当于一个常数项。

- 在更新生成器参数时,我们使用$\tilde{V}=\frac{1}{m} \sum_{i=1}^{m} -\log \left(D\left(G\left(z^{i}\right)\right)\right)$代替$\tilde{V}=\frac{1}{m} \sum_{i=1}^{m} \log \left(1-D\left(G\left(z^{i}\right)\right)\right)$,这样做的目的是加速训练过程。

生成对抗网络的优化

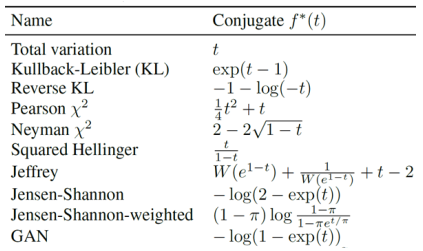

fGAN

通过上面的分析我们可以知道,构建生成模型需要解决的关键问题是最小化$P_G$和$P_{data}$之间的距离,这就涉及到如何对$P_G$和$P_{data}$之间的距离进行度量。在上述GAN的分析中,我们通过构建一个判别器来对$P_G$和$P_{data}$之间的距离进行度量,其中采用的目标函数为:

$$

V(G, D)=E_{x \sim P_{\text {data }}}[\log D(x)]+E_{x \sim P_{G}}[\log (1-D(x))]

$$

通过证明可知,$V(G, D)$其实度量的是$P_G$和$P_{data}$之间的$JS$散度。如果我们希望采用其他方式来衡量两个分布之间的距离,则需要对判别器的目标函数进行修改。根据论文fGAN,可以将判别器的目标函数定义成如下形式:

$$

D_{f^{*}}(P_{\text {data }} | P_{G})=\max_{\mathrm{D}}{E_{x \sim P_{\text {data }}}[D(x)]-E_{x \sim P_{G}}[f^{*}(D(x)]}

$$

则$G^{*}$可以表示为:

$$

G^{*}=arg \min_{G} D_{f^{*}}\left(P_{\text {data }} | P_{G}\right)

$$

$f^{*}$取不同表达式时,即表示不同的距离度量方式。

令$f^{*}(t)=-log(1-exp(t))$,$D(x)$取$log$,代入$D_{f^{*}}\left(P_{\text {data }} | P_{G}\right)$即可得到$V(G,D)$。

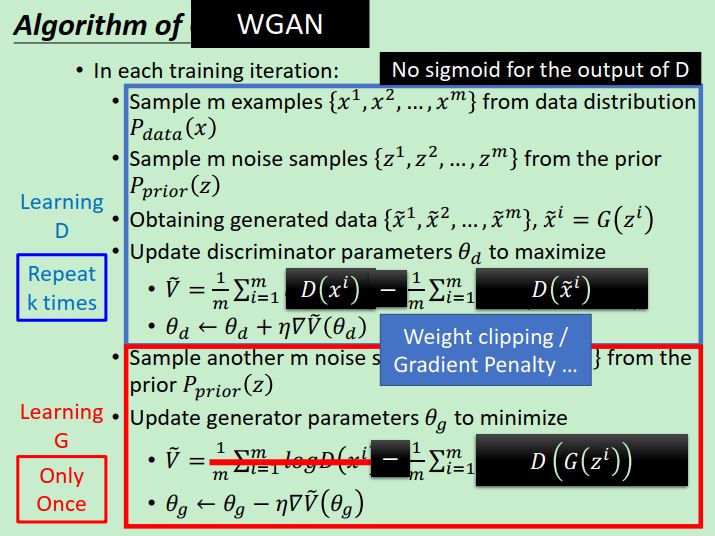

WGAN

自2014年Goodfellow提出以来,GAN就存在着训练困难、生成器和判别器的loss无法指示训练进程、生成样本缺乏多样性等问题。针对这些问题,Martin Arjovsky进行了严密的理论分析,并提出了解决方案,即WGAN(WGAN的详细解读可参考这篇博客)。

判别器越好,生成器梯度消失越严重。根据上面的分析可知,当判别器训练到最优时,$\max _{D} V(D, G)$衡量的是$P_G$与$P_{data}$之间的$JS$散度。问题就出在这个JS散度上,我们希望如果两个分布之间越接近它们的JS散度越小,通过优化JS散度就能将$P_G$拉向$P_{adta}$。这个希望在两个分布有所重叠的时候是成立的,但是如果两个分布完全没有重叠的部分,或者它们重叠的部分可忽略,$J S D\left(P_{\text {data }} | P_{G}\right)=log2$。在训练过程中,$P_G$与$P_{data}$都是通过采样得到的,在高维空间中两者之间几乎不存在交集,从而导致$\max _{D} V(D, G)$接近于0,生成器因此也无法得到有效训练。

最小化生成器loss函数$E_{x \sim P_{G}}[\log (1-D(x))$,会等价于最小化一个不合理的距离衡量,导致两个问题,一是梯度不稳定,二是collapse mode即多样性不足。假设当前的判别器最优,经过推导可以得到下面等式:

$$

E_{x \sim P_{G}}[\log (1-D(x))=KL\left(P_{\text {G }} | P_{data}\right)-2 J S D\left(P_{\text {data }} | P_{G}\right)

$$

这个等价最小化目标存在两个严重的问题。第一是它同时要最小化生成分布与真实分布的KL散度,却又要最大化两者的JS散度,一个要拉近,一个却要推远!这在直观上非常荒谬,在数值上则会导致梯度不稳定,这是后面那个JS散度项的毛病。第二,即便是前面那个正常的KL散度项也有毛病,因为KL散度不是一个对称的衡量$KL\left(P_{\text {G }} | P_{data}\right)$和$KL\left(P_{\text {data}} | P_{G}\right)$是有差别的。原始GAN的主要问题就出在距离度量方式上面,Martin Arjovsky提出利用Wasserstein距离来进行衡量。Wasserstein距离相比KL散度、JS散度的优越性在于,即便两个分布没有重叠,Wasserstein距离仍然能够反映它们的远近。

$$

W(G, D)=E_{x \sim P_{\text {data }}}[D(x)]-E_{x \sim P_{G}}[D(x)]\

$$

由以上算法可以看出,WGAN与原始的GAN在算法实现方面只有四处不同:(1)判别器最后一层去掉sigmoid;(2)生成器和判别器的loss不取log;(3)每次更新判别器的参数之后把它们的绝对值截断到不超过一个固定常数c;(4)不要用基于动量的优化算法(包括momentum和Adam),推荐RMSProp,SGD也行。

生成对抗网络的实现

本文实现了几种常见的生成对抗网络模型,包括原始GAN、CGAN、WGAN、DCGAN。开发环境为jupyter lab,所使用的深度学习框架为pytorch,并结合tensorboard动态观测生成器的训练效果,具体代码请参考我的github。

GAN

1 | real_label = torch.ones(batch_size, 1) |

CGAN

1 | real_label = torch.ones(batch_size, 1) |

WGAN

1 | # 训练判别器 |

本文作者:光阴的故事

本文链接: 生成对抗网络.html/

版权声明: 本博客所有文章除特别声明外,均采用 CC BY-NC-SA 3.0 CN 许可协议。转载请注明出处!